Kurzfassung: Für einen Industrie-Kunden haben wir einen Chatbot implementiert, der Nutzerfragen nicht „aus dem Kopf“ beantwortet, sondern gezielt angebundene Tools nutzt: Artikel-Lookup, Datenblattabruf und Wissenszugriff – alles protokolliert, reproduzierbar und DSGVO-konform. Der Bot läuft auf n8n mit OpenAI-kompatibler Webhook-Schnittstelle und Azure OpenAI (EU-Kontext), inklusive Sessionspeicher und Intent-Routing.

Ausgangslage & Ziel

Technische Anfragen zu Industrieartikeln sind komplex: Artikelnummern variieren, Nachfolger existieren, und Spezifikationen müssen belastbar sein. Ziel war ein robuster Chat-Workflow, der:

- Nutzerfragen annimmt (OpenAI-API-kompatibel),

- Intent & Parameter (z. B. Artikelnummer, Hersteller) sauber extrahiert,

- hersteller-spezifische Datenquellen bzw. freigegebene Crawler/Workflows ansteuert,

- nur belegbare Informationen zurückgibt – mit Quellen aus den Tools.

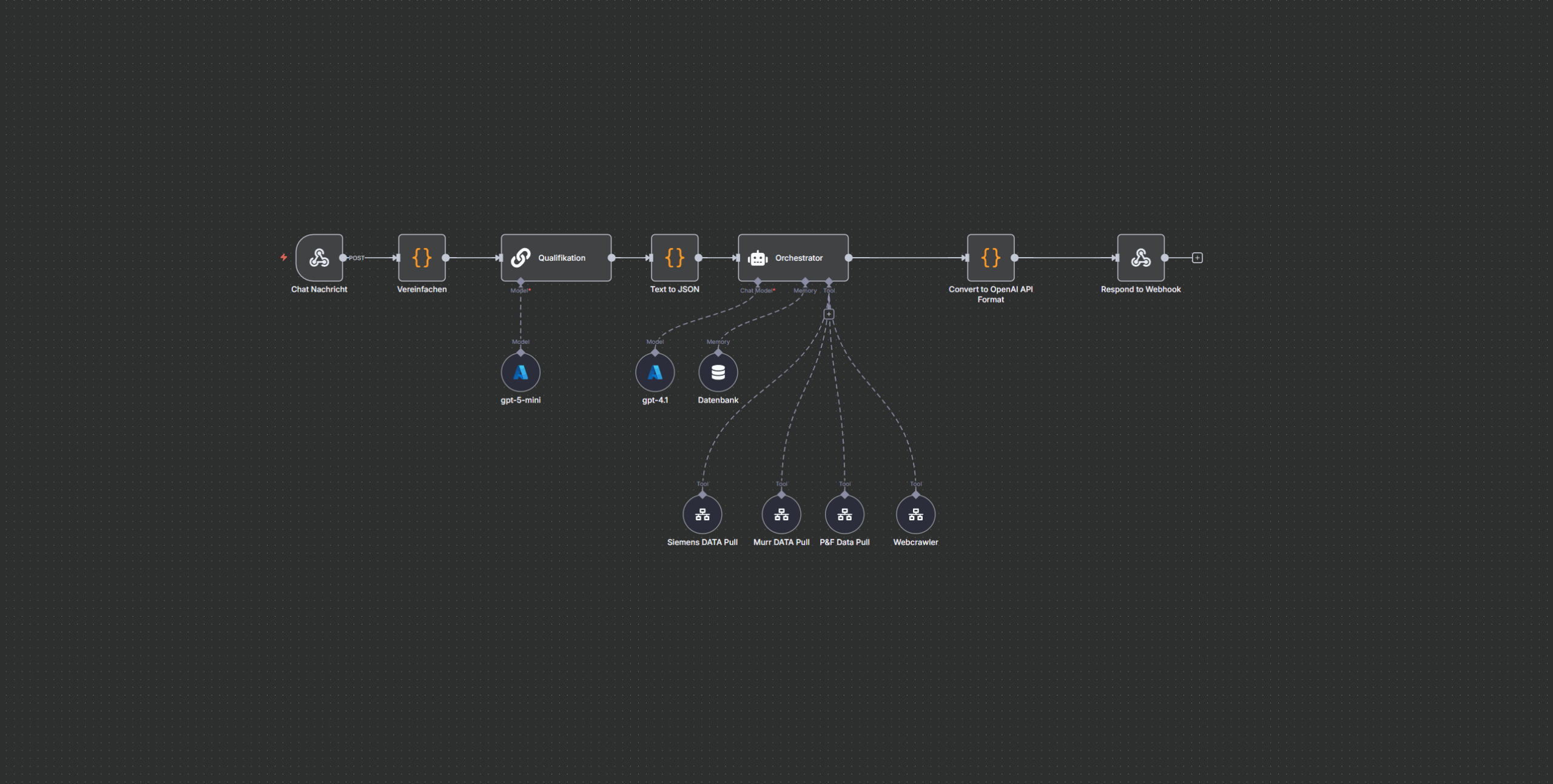

Architektur im Überblick

- Webhook (POST /v1/chat/completions): OpenAI-kompatible Endpoint-Struktur für einfache Integration.

- Pre-Processing („Vereinfachen“): Extrahiert Session-Key, letzte Usernachricht, Metadaten (IP/User-Agent optional).

- Intent-Router („Qualifikation“): Klassifiziert Anfrage (z. B. article_lookup, free_text_search, knowledge_db_query) und liefert ein valide geparstes JSON.

- Memory (Session): Buffer Window Memory per Session-Key für zusammenhängende Dialoge.

- Orchestrator-Agent: Strenge Tools-first-Policy: Erst passende Workflows aufrufen (z. B. Artikel-Lookup, PDF-Abruf, Parser, Specs-Extraktion), dann antworten.

- Tool-Workflows:

- Hersteller-spezifische Pull-Workflows (nur wenn freigegeben).

- Fallback-Crawler für generische Abfragen.

- Compliance & Determinismus: Keine freien Vermutungen, nur toolbasierte Ergebnisse mit Quellen.

- Response-Formatter: Konvertiert die Ausgabe in ein OpenAI-API-konformes Chat-Completion-Objekt.

Wichtiger Hinweis: Es werden keine vertraulichen/geschützten Inhalte offengelegt. Der Beitrag enthält keine Details zu konkreten Scraping-Zielen oder proprietären Endpunkten.

Funktionsweise Schritt für Schritt

- Request entgegennehmen: Client postet Chat-Nachrichten an den Webhook (OpenAI-Format).

- Session & Frage extrahieren: Session-Key, letzte Userfrage, gewünschtes Modell.

- Intent-Erkennung: Parser liefert rein JSON-basiert: Intent, Sprache, erkannte Artikelnummer/Hersteller, Confidence.

- Tool-Planung: Orchestrator wählt das zuständige Workflow-Tool (z. B. Hersteller-Lookup → Datenblatt → Parser → Specs).

- Ausführung & Validierung: Ergebnisse werden auf Vollständigkeit geprüft (z. B. Spannung, Strom, Abmessungen, IP-Schutzklasse).

- Antwort bauen: Knapp, sachlich, mit Quellen (nur aus Tool-Outputs).

- Rückgabe: OpenAI-kompatibles JSON (choices, message, usage).

Warum dieser Ansatz?

- Verlässlich statt generativ unscharf: Der Bot „weiß“ nichts – er verwaltet Wissen und zitiert nur Tool-Ergebnisse.

- Auditierbar: Jeder Schritt ist in n8n nachvollziehbar (Logs, Status).

- Skalierbar: Neue Hersteller/Datenquellen werden als Tool-Workflow ergänzt.

- EU & DSGVO: Betrieb mit Azure OpenAI (EU-Konfiguration) und klaren Zugriffs-/Compliance-Regeln.

Sicherheits- & Compliance-Prinzipien

- Tools-first, Knowledge-last: Keine Freitexterfindungen.

- Quellenpflicht: Nur verlinkte/benannte Tool-Outputs.

- Minimal-Rückfragen: Nur wenn essenzielle Parameter fehlen (z. B. Hersteller, MLFB).

- Keine Secrets/IDs im Output, keine personenbezogenen Daten ohne Freigabe.

- EU-Hosting präferiert, Logs & Rechtekonzepte inklusive.

Nutzen für Fachabteilungen

- Schnellere Antworten auf wiederkehrende Technikfragen.

- Weniger Rückfragen durch saubere Parametrisierung und Nachfolger-Hinweise.

- Wissensentlastung im Support: Der Bot übernimmt Erstklärung & Spezifikats-Auszug.

- Konsistente Qualität dank deterministischer Pipelines.

Erweiterungen (Roadmap)

- Streaming-Antworten am Webhook für Live-Token-Output.

- Mehrsprachigkeit mit Terminologie-Glossar.

- RAG auf freigegebenen internen Dokumenten (rollenbasiert).

- Telemetry & Monitoring (Fehlerraten, Tool-Latenzen, Antwortqualität).

- Admin-Konsole zum Verwalten von Tools, Limits, Session-Policies.

Fazit

Mit n8n als Orchestrierungs-Layer und Azure OpenAI als Modell-Backend entsteht ein verlässlicher Industrie-Chatbot, der nur belegbare Informationen aus angebundenen Hersteller-/Wissens-Workflows liefert. Das reduziert Fehlantworten, schafft Vertrauen und spart Support-Zeit – DSGVO-konform und erweiterbar.